PARTNERS

LOCATION

- 장소

- 코엑스 그랜드볼룸 (Coex Grand Ballroom)

- 주소

- 서울 강남구 영동대로 513 코엑스, (지번) 삼성동 159 코엑스

- 연락처

- 02-6000-0114

그랜드볼룸은 봉은사 맞은편 코엑스 1층 북문 쪽에 위치해 있습니다.

지하철 이용 시 9호선 봉은사역 7번 출구를 이용하시거나 삼성역 6번 출구를

이용하시면 됩니다.

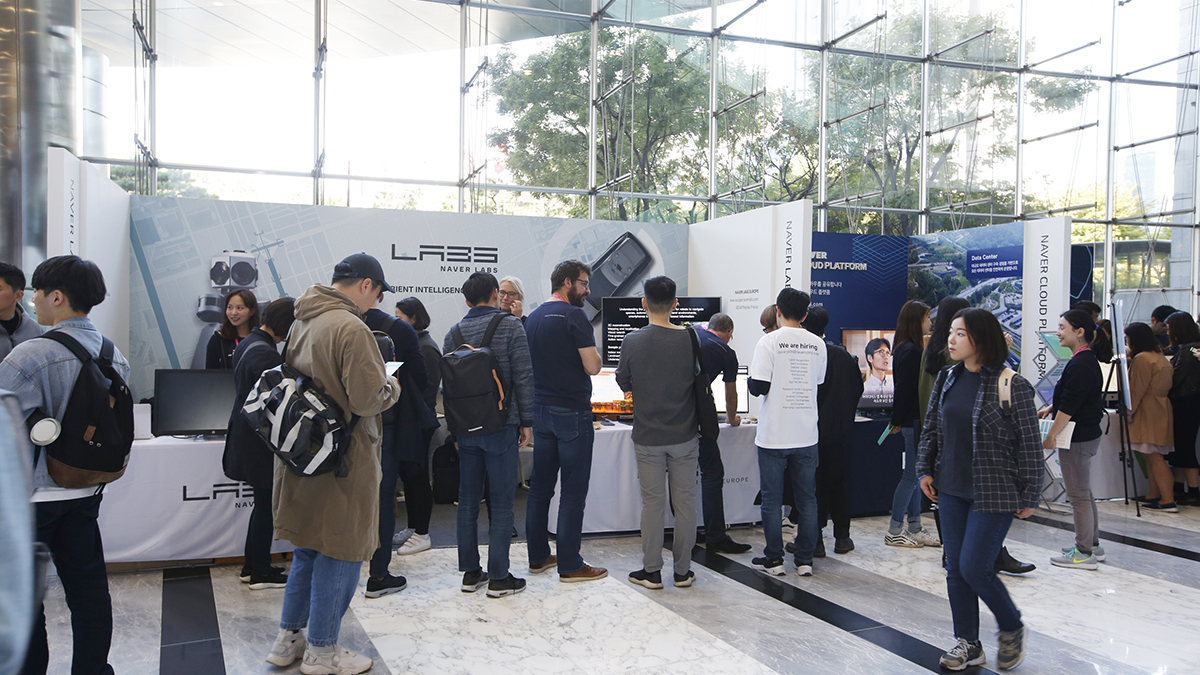

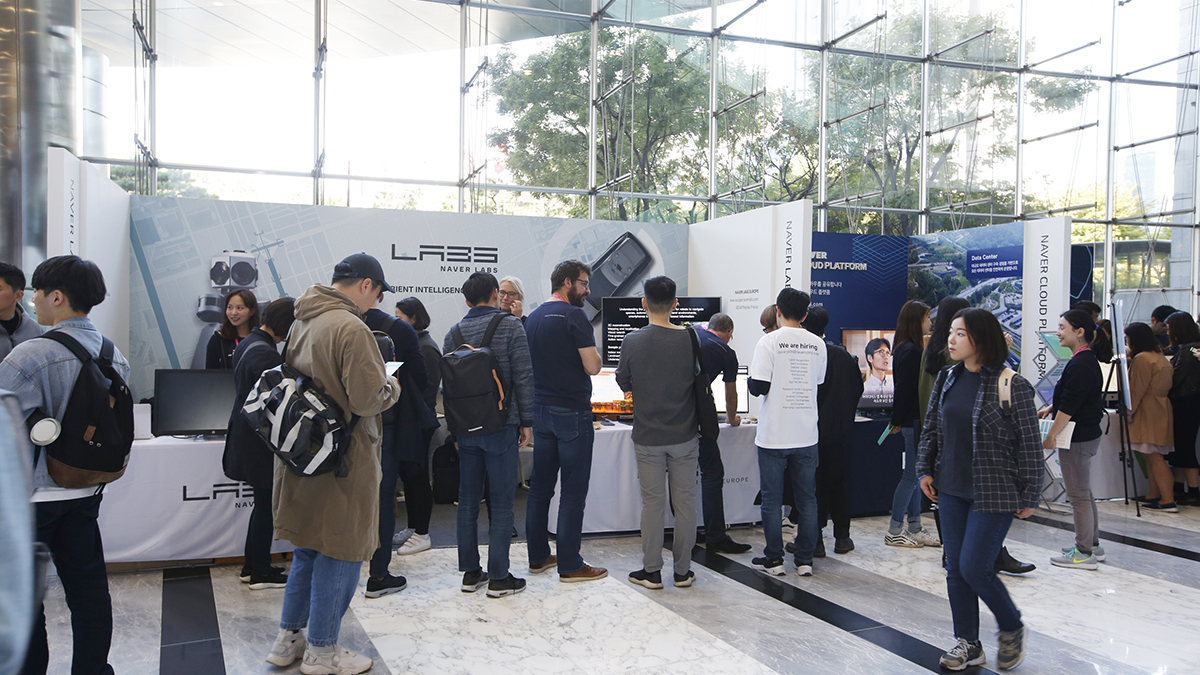

2018. 10. 11-12 COEX Grand Ballroom, Seoul

그랜드볼룸은 봉은사 맞은편 코엑스 1층 북문 쪽에 위치해 있습니다.

지하철 이용 시 9호선 봉은사역 7번 출구를 이용하시거나 삼성역 6번 출구를

이용하시면 됩니다.